Seis dedos nas mãos, rosto que parece não pertencer ao corpo, olhar que não acompanha os movimentos, braço mexendo de forma estranha.

Até aqui, são problemas comuns às imagens sintéticas geradas por inteligência artificial (IA).

Os defeitos aparentes permitiam a detecção de uso de IA a partir de um simples olhar. Daqui em diante, no entanto, especialistas alertam que só a análise humana não será mais suficiente nesse processo.

"Essa janela está se fechando", alerta Mike Speirs da Faculty AI, consultoria com sede em Londres que desenvolve modelos de detecção de conteúdo sintético (produzido por, ou com a ajuda, de IA).

"Há um constante refinamento dos modelos com base na natureza quase adversária entre quem gera (conteúdo) e quem trabalha para identificar", acrescenta.

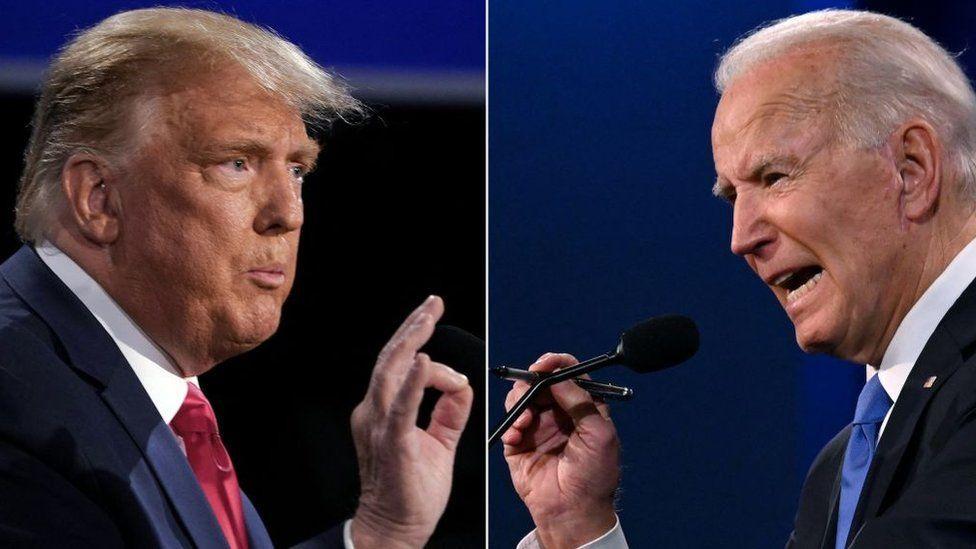

Em um ano no qual cerca de 50 eleições serão realizadas pelo mundo, inclusive no Brasil, especialistas e governos tentam se preparar para os possíveis usos dos modelos de IA na criação de narrativas de desinformação a fim de influenciar resultados.

O desafio é grande.

Os modelos que geram conteúdo por IA aprendem com as falhas identificadas por usuários e métodos de detecção.

Assim, tanto profissionais humanos quanto mecanismos desenvolvidos para detectar uso de IA em um áudio ou imagem fixa ou em movimento precisam acompanhar as melhorias feitas pelos sistemas "adversários" de criação de conteúdo sintético para entender as novas falhas e assim poder encontrá-las.

À medida que os modelos de geração de conteúdo e a detecção evoluem, as falhas ficam cada vez menos evidentes, especialmente a olho nu.

"As formas pelas quais entendemos que o conteúdo é sintético hoje talvez não sejam válidas amanhã", diz Carlos Affonso Souza, diretor do Instituto de Tecnologia do Rio de Janeiro, acrescentando, no entanto, que as aplicações mais populares ainda deixam passar mãos com mais de cinco dedos.

Oren Etzioni, professor emérito da Universidade de Washington e pesquisador na área de IA, é enfático: "É uma corrida de armas. E chegamos num ponto em que é extremamente difícil fazer essa avaliação sem uso de modelos de IA treinados para isso".

No entanto, o acesso a ferramentas de detecção de conteúdo sintético ou manipulado ainda é bastante restrito. Em geral, está nas mãos de quem é capaz de desenvolvê-las, ou de governos.

"Se você não tem como saber o que é verdade, você não está em um bom lugar", acrescenta.

Souza, do ITS-Rio, diz que um dos desafios que se apresenta é o de constantemente treinar e atualizar não só os modelos de detecção para reconhecer conteúdo manipulado ou produzido com IA, mas também educar os seres humanos expostos a eles.

"Estamos hoje pouco equipados, tanto em termos de tecnologia quanto em termos de metodologia para lidar com esse debate," diz. "Vamos precisar nos valer das ferramentas de educação digital, educando e atualizando a sociedade constantemente sobre o tema."

Speirs concorda. "É um problema mais amplo, da sociedade, no qual a tecnologia desempenha um papel importante. Assim, além de haver investimento para a detecção, deve haver também para educação midiática".

Etzioni se diz, em geral, um otimista em relação à IA, mas reconhece o tamanho do problema, sobretudo para o processo eleitoral.

"As redes sociais nos deram a capacidade de compartilhar informação facilmente. Mas a capacidade de gerar conteúdo ainda pertencia às pessoas. Com IA isso mudou, e o custo de produzir conteúdo caiu para zero. Este ano será crucial para entendermos o potencial disso na desinformação".

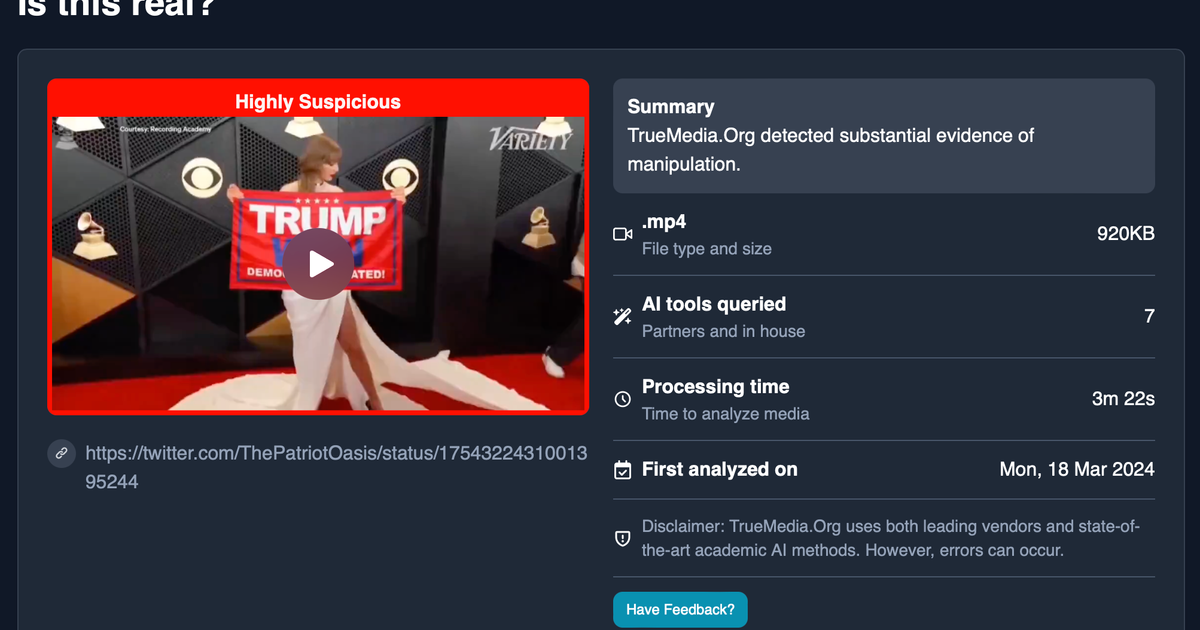

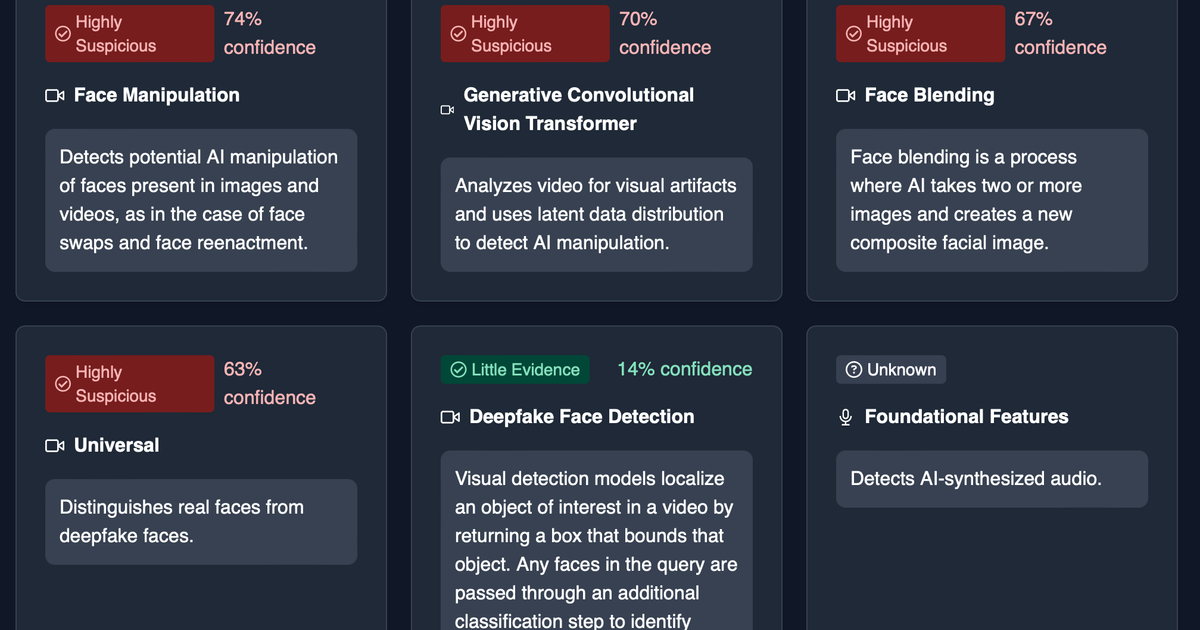

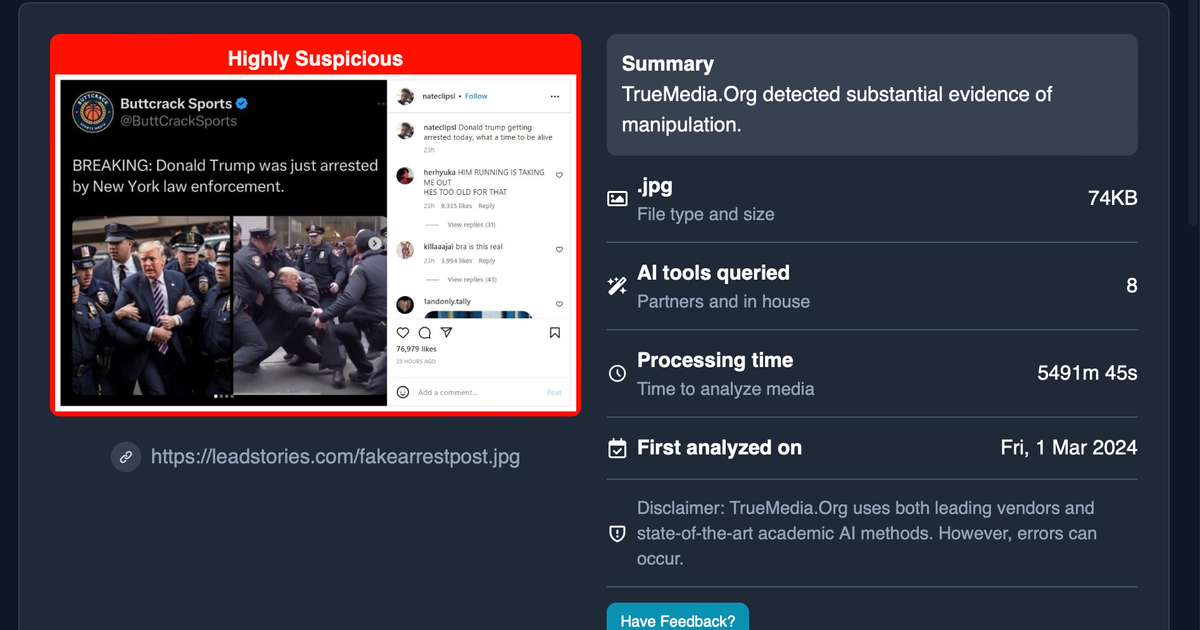

Temendo o impacto no ecossistema informacional, especialmente com o uso de deep fakes nas eleições presidenciais dos Estados Unidos, Etzioni criou uma ferramenta de detecção sem fins lucrativos, a True Media, que está sendo oferecida gratuitamente a jornalistas.

O conteúdo é analisado pelos modelos de IA da organização em minutos, e o usuário recebe uma estimativa da probabilidade de o conteúdo ser sintético ou manipulado.

"Num mundo em que as pessoas podem ser facilmente manipuladas, é importante que a imprensa seja parte da solução".

No Brasil, o receio diante do impacto que a geração de conteúdo por IA terá no processo eleitoral não é menor.

Num esforço de se antecipar às possíveis questões que surgirão, como a dificuldade de rapidamente se saber se um conteúdo foi gerado ou manipulado por IA, e evitar que narrativas falsas se propaguem apoiadas em conteúdo sintético, o Tribunal Superior Eleitoral (TSE) atualizou, em janeiro, as regras de propaganda eleitoral, definindo os usos possíveis de IA.

Conteúdos gerados com ferramentas de IA serão permitidos desde que sinalizados pelas campanhas, deep fakes estão vedados e as plataformas devem remover de forma "imediata" esses — e outros — conteúdos que violem as regras, sob risco de serem responsabilizadas civil ou administrativamente, segundo as regras.

Ao proibir deep fakes e exigir remoção imediata desse tipo de conteúdo, o desafio da detecção fica com as plataformas.

Para Francisco Brito Cruz, diretor-executivo do InternetLab, as novas regras obrigam as empresas de tecnologia a exercer maior fiscalização e moderação dos conteúdos que circulam nelas.

"Hoje em dia elas não têm incentivo jurídico para proibir deep fake em seus termos de uso e moderar esse tipo de conteúdo sem ordem judicial. Fazem porque querem, mas não são obrigadas. E só vão ser responsabilizadas após o descumprimento de uma ordem. Com a nova resolução, vai ter quem ache que elas precisam agir, sim (antes de receber ordem judicial)," alerta.

Souza, do ITS, vê a medida com ressalvas.

"Estou entendendo que o TSE vai terceirizar, de certa forma, essa primeira linha de combate para as plataformas. E, se elas falharem, serão responsabilizadas. É, de certa maneira, achar que o regime de responsabilização é, por si só, incentivo suficiente para que as empresas adotem meios de identificação de conteúdo sintético. Me parece insuficiente para que isso se desenvolva," analisa.

Nas eleições de 2022, as plataformas tinham um prazo de duas horas após o recebimento de ordem judicial para removerem conteúdos ou contas.

O texto atual não deixa claro se elas terão que fazer monitoramento ativo para encontrar e imediatamente remover esses conteúdos, ou se a exigência de remoção imediata diz respeito apenas a contas e conteúdos alvo de ordem judicial, gerando ampla discussão entre especialistas de direito digital.

A coordenadora de liberdade de expressão do InternetLab e de eleições da Coalizão Direitos na Rede, Iná Jost, diz que exigir remoção imediata de conteúdo sem citar a necessidade de uma ordem judicial está em desacordo com o Marco Civil da Internet e a Lei de Eleições.

"Precisamos de mais informações. Uma remoção ativa de conteúdo sem haver parâmetros muito claros, legais, de regulamentação, expõe o discurso a uma restrição indevida que pode ser muito prejudicial para o debate de ideias", diz.

E o risco do monitoramento ativo, alerta Souza, é um número alto de falsos positivos, ou seja, conteúdo removido como sendo IA, quando na verdade não é.

"Isso tudo vai ganhar uma conotação política. E você vai ter partes prejudicadas com a análise do conteúdo dizendo que a remoção foi feita para favorecer um ou outro candidato, e que a plataforma atua viés."

E alerta: "Podemos esperar que toda discussão sobre conteúdo sintético, e as armadilhas que estamos construindo para nós mesmos com esse sistema de responsabilidade vão fomentar narrativas de desinformação amplamente apoiadas em inteligência artificial."

A reportagem entrou em contato com o TSE, mas não recebeu resposta até o fechamento.

Nesta quarta-feira (29/5) o Congresso Nacional resolveu por ampla margem manter o veto feito pelo então presidente Jair Bolsonaro à Lei de Segurança Nacional. Entre os trechos vetados, estão o que criminalizava a comunicação enganosa em massa, as chamadas fake news,

Notou alguma informação incorreta no conteúdo de A Gazeta? Nos ajude a corrigir o mais rapido possível! Clique no botão ao lado e envie sua mensagem

Envie sua sugestão, comentário ou crítica diretamente aos editores de A Gazeta